Estimación de Profundidad y Segmentación Semántica

Actualmente, la creciente disponibilidad de cámaras hace de la captura de imágenes una realidad cotidiana, acelerando la cantidad de datos visuales generados diariamente. El entendimiento del contenido de cada imagen, sin embargo, es una tarea compleja y asociada generalmente a la inteligencia humana.

Al tomar una imagen, una escena en tres dimensiones es convertida a un plano. La imagen puede ser vista como una simplificación de una escena compleja a un conjunto de valores que representan información de color en cada posición, denominados píxeles. Entender de manera automática la escena consiste en diseñar algoritmos que obtengan información de alto nivel a partir de dicho conjunto de valores. La tarea de diseñar un algoritmo capaz de tomar en cuenta la inconmensurable cantidad de variaciones que se pueden producir en una imagen se torna, en la práctica, imposible. Por esta razón, atacar el problema aprendiendo de los datos con los que se cuentan, en reemplazo del diseño rígido de un algoritmo, parece ser la única solución viable.

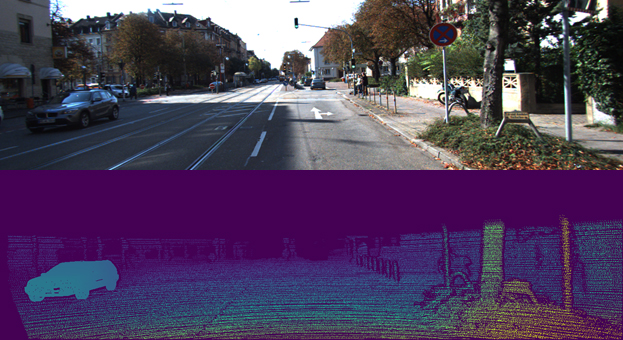

En los últimos años, los avances en Deep Learning han permitido, junto a la creciente disponibilidad de datos, que el entendimiento de la escena deje de ser una utopía y se transforme en una realidad. El entendimiento geométrico de la escena, es decir, de la distancia de los objetos a la cámara, y el reconocimiento de los objetos que forman dicha escena, son dos objetivos de la Visión Artificial denominados Estimación de Profundidad y Segmentación Semántica, respectivamente.

En el VyGLab trabajamos en ambos tópicos, investigando nuevas técnicas y mejoras en las fronteras del Deep Learning, experimentando con conjuntos de datos de problemáticas actuales, como imágenes urbanas para el desarrollo de autos autónomos.

Están Involucrados en esta Línea...

Ing. Juan I. Larregui

Dra. Silvia M. Castro